Bon, apparemment il suffit que des puces Nvidia soient “tombées du camion” pour qu’un milliard de dollars de GPU ultra puissants se retrouvent sur le marché noir chinois. Le Financial Times a enquêté et ce qu’ils ont découvert est assez dingue.

Alors que les États-Unis font tout pour empêcher la Chine d’accéder aux dernières technologies d’IA, des B200, H100 et H200 de Nvidia circulent tranquillement sur les réseaux sociaux chinois. Leur prix ? 50% au-dessus du tarif normal, mais visiblement ça ne freine personne. Les vendeurs proposent même des racks pré-assemblés avec 8 puces B200, prêts à brancher dans un datacenter. Genre tu commandes sur WeChat et hop, tu reçois ton rack de 150 kilos à 560 000 dollars.

D’après l’enquête du FT, rien qu’entre avril et juin 2025, c’est plus d’un milliard de dollars de matos qui aurait transité. Les puces passent par la Thaïlande, la Malaisie, et d’autres pays d’Asie du Sud-Est où les contrôles sont… disons plus souples. La Malaisie a d’ailleurs vu ses importations de GPU avancés exploser de 3400% début 2025. Coïncidence ? Je ne crois pas…

Le plus ironique dans l’histoire, c’est que ces restrictions viennent juste d’être assouplies pour les puces moins puissantes comme la H20. Mais bon, pourquoi se contenter d’une 2CV quand on peut avoir une Ferrari, même au marché noir ?

Une boîte chinoise basée à Shanghai, “Gate of the Era” (ça ne s’invente pas), créée en février juste avant que les restrictions ne tombent (le timing est parfait), aurait à elle seule écoulé pour 400 millions de dollars de systèmes B200. Ils vendent même des racks complets entre 3,9 et 3,95 millions de yuans pièce.

Un rack de B200

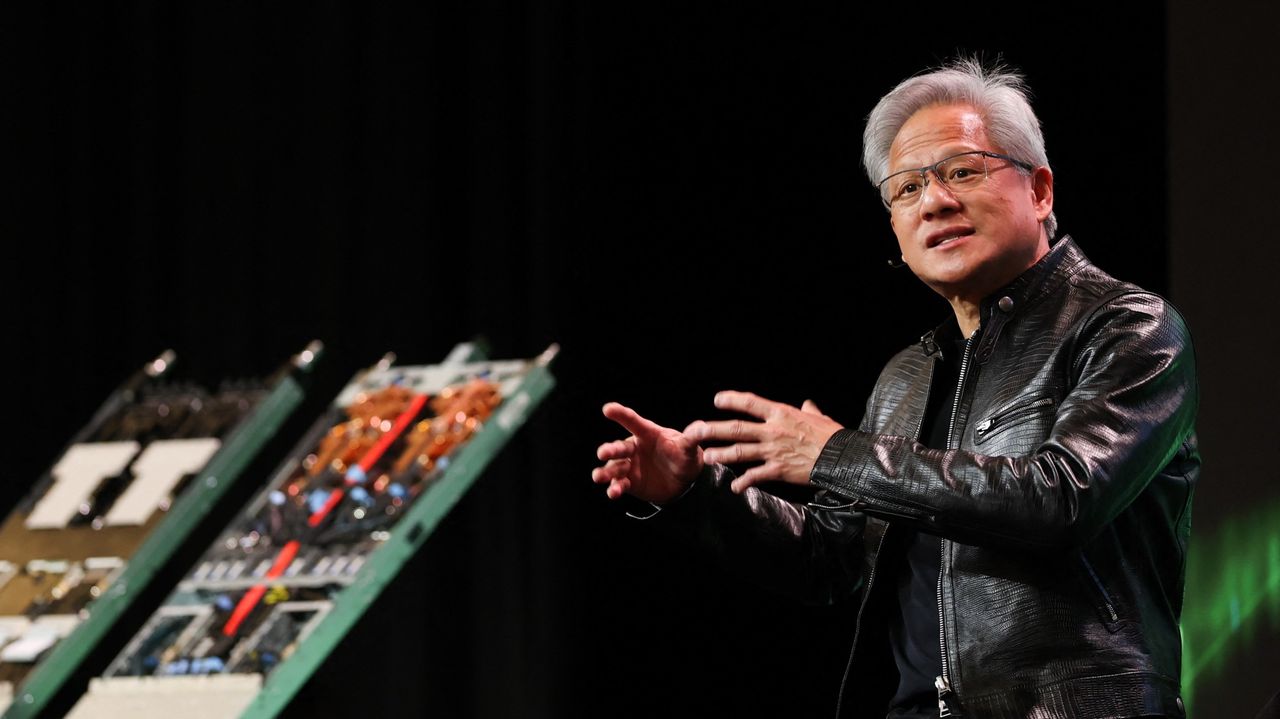

Et Nvidia, de son côté, fait la sourde oreille. Leur réponse officielle ? “Nous ne fournissons support et service qu’aux produits Nvidia autorisés”. Traduction : démerdez-vous avec vos GPU de contrebande. Mais bon, avec une valorisation de 4000 milliards de dollars, ils vont pas trop pleurer sur quelques puces qui s’égarent.

Ce qui est fascinant, c’est comment les Chinois ont industrialisé le contournement. Les vendeurs testent même les puces avant de les vendre pour garantir qu’elles fonctionnent. Service après-vente inclus apparemment. Un opérateur de datacenter chinois l’a dit cash au FT : “Les contrôles à l’export n’empêcheront pas les produits les plus avancés de Nvidia d’entrer en Chine. Ça ajoute juste de l’inefficacité et crée d’énormes profits pour les intermédiaires prêts à prendre des risques.”

Pendant ce temps, DeepSeek et d’autres boîtes d’IA chinoises prétendent faire aussi bien que les modèles américains avec beaucoup moins de ressources, mais visiblement, ça ne les empêche pas de quand même vouloir mettre la main sur les derniers joujoux de Nvidia.

Jensen Huang, le CEO de Nvidia né à Taiwan, voit toujours la Chine comme une opportunité énorme. C’est d’ailleurs lui qui aurait négocié avec Trump pour assouplir certaines restrictions. Mais pour les B200 et H100, c’est toujours un niet officiel !

Le gouvernement américain essaie surtout pendant ce temps de boucher les trous. Le Department of Commerce envisage par exemple d’imposer des contrôles plus stricts sur des pays comme la Thaïlande dès septembre. Mais franchement, quand y’a autant d’argent en jeu, croyez-moi, les contrebandiers trouveront toujours un moyen.

Au final, cette histoire montre bien les limites d’une guerre commerciale technologique. C’est un peu comme la drogue… Tu peux interdire, restreindre, sanctionner, mais quand la demande est là et que les profits sont juteux, le marché trouve toujours un chemin où les seuls qui s’enrichissent vraiment, ce sont les intermédiaires qui prennent leur commission de 50% au passage.

Source