Unitree G1 – Le robot humanoïde à tout faire pour 16 000$

Unitree, le fabricant chinois de robots bien connu (sauf par moi visiblement) pour ses quadrupèdes comme le Go2 et le B2, nous réserve une sacrée surprise avec son nouveau robot humanoïde baptisé G1. Et apparemment, ce n’est pas un gadget de geek.

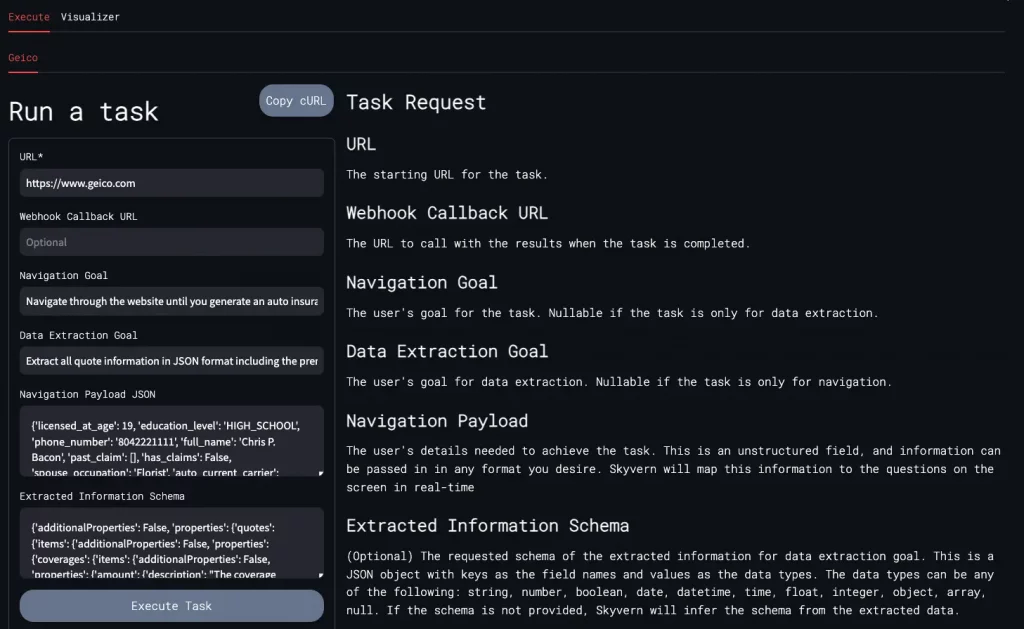

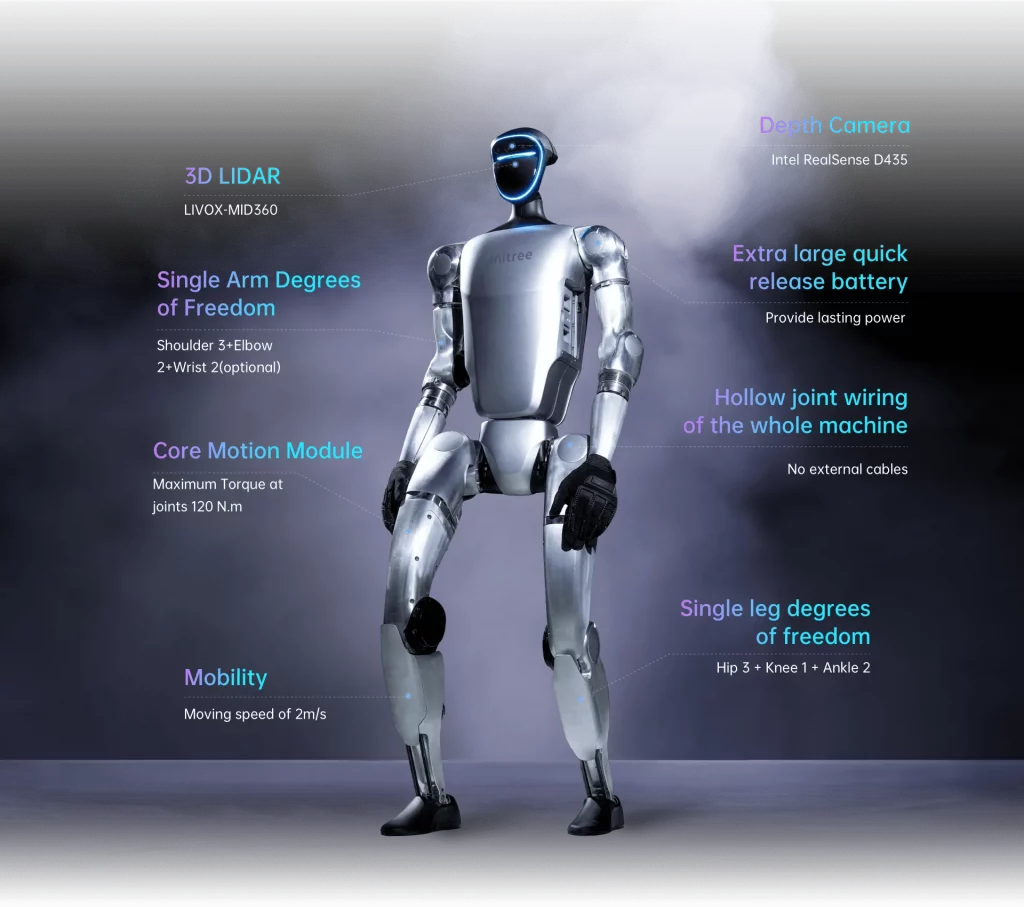

Avec un prix de départ à 16 000 $, le G1 est une « affaire intéressante » comparé à d’autres robots humanoïdes comme l’Atlas de Boston Dynamics (qui coûte bien plus cher). Ce qui frappe d’emblée quand on regarde la vidéo, c’est la flexibilité hallucinante de ce robot. Grâce à ses 23 degrés de liberté dans les articulations, il peut bouger dans tous les sens, bien au-delà des capacités humaines. C’est un peu flippant ^^. Il peut même se plier pour se ranger facilement dans un coin.

Mais ce n’est pas qu’un contorsionniste en manque de reconnaissance. C’est aussi un sacré costaud avec ses 35kg (ou 47 kg… les infos divergent…) et sa vitesse de déplacement de 2 m/s. Ses moteurs délivrent jusqu’à 120 Nm de couple, de quoi soulever des charges d’environ 3 kg avec ses petits bras. Et avec sa batterie de 9000 mAh, il peut tenir environ 2 heures sur une seule charge (sur le papier). Bref, de quoi l’utiliser pour divers travaux sans craindre qu’il tombe à plat trop vite.

Côté look, Unitree a joué la carte du robot futuriste avec son casque aux allures de Daft Punk et son visage illuminé qui cache des capteurs 3D LiDAR et une caméra de profondeur. Mais ce sont surtout ses mains robotiques à trois doigts qui impressionnent le plus. Elles lui permettent d’attraper et de manipuler des objets avec une précision et une dextérité bluffantes.

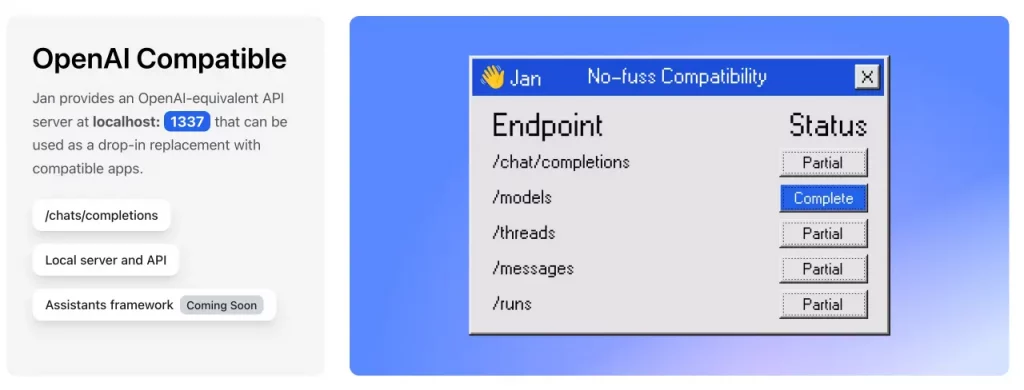

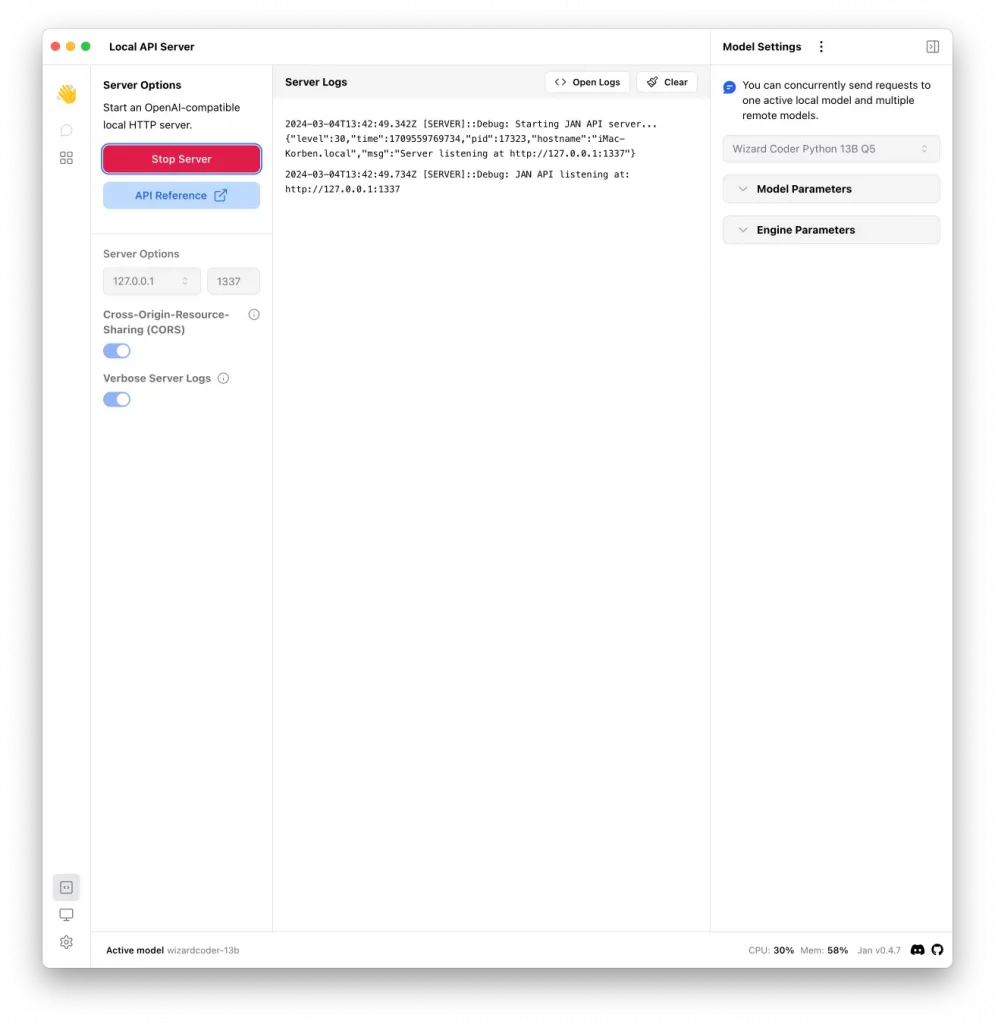

Ce robot apprend aussi en permanence grâce à des techniques d’imitation et d’apprentissage par renforcement. Il peut simuler les mouvements humains et acquérir de nouvelles compétences au fur et à mesure. Son cerveau embarque 8 cœurs haute performance pour un traitement ultra-rapide des informations. Et avec le WiFi 6 et le Bluetooth 5.2, il est hyper connecté ! Pour ceux qui cherchent à le développer davantage, le modèle G1 EDU inclut même en option le module de calcul haute performance NVIDIA Jetson Orin.

Alors Terminator en devenir ou pas ? Bien qu’il puisse encaisser des coups, il reste très docile. Enfin, pour l’instant… Car Unitree prévoit de l’entraîner dans des environnements simulés pour muscler encore plus son IA.

Bref, ce G1 de Unitree apporte un peu de fraicheur, surtout qu’à ce prix, ça commence à devenir accessible pour le commun des friqués. Certaines de ses fonctionnalités impressionnantes sont encore en développement, mais avec le rythme auquel avancent les technologies robotiques, ce n’est qu’une question de temps avant qu’il ne devienne encore plus polyvalent et sache se rendre indispensable.

Bref, pour en savoir plus, rendez vous sur le site Unitree.

Perso, je me porte volontaire pour le tester.