Sam Altman says current computer form factors aren't designed to deliver the "sci-fi dream" of an AI companion like ChatGPT

An image of a woman holding a laptop in front of a ChatGPT logo displayed on a computer screen.

![]()

An image of a woman holding a laptop in front of a ChatGPT logo displayed on a computer screen.

![]()

SoftBank's Pepper humanoid robot stands on display during the SoftBank World 2018 conference on July 19, 2018 in Tokyo, Japan.

![]()

Sam Altman speaks onstage during The New York Times Dealbook Summit 2024.

![]()

A close-up shot of a student's hand throwing a hat into the sky during a graduation celebration

![]()

Geekom A8 design showcase

![]()

Sam Altman Co-founder and CEO of OpenAI speaks during the Italian Tech Week 2024

![]()

AORUS GeForce RTX 4070 Ti Master 12G review

![]()

U.S. President Donald Trump speaks in the Oval Office on August 14, 2025 in Washington, DC.

![]()

The ChatGPT app is seen on a mobile device.

![]()

![]()

If you love beautiful hair but dread the countertop clutter from too many styling tools, the new FlexFusion by LAYER and Shark Beauty could be the answer you’ve been waiting for. This device brings together five essential hair styling tools into one streamlined, elegant system that’s designed to fit every beauty routine and lifestyle.

FlexFusion was created by experience design agency LAYER, led by founder Benjamin Hubert, in close partnership with Shark Beauty. The result is a modular 5-in-1 hair styling tool that merges a ceramic straightener, hot brush, auto-wrap curlers, concentrator, and diffuser. Whether you’re looking to smooth, straighten, curl, or define your hair’s natural texture, FlexFusion makes it simple to achieve your favorite looks without juggling multiple devices. Each attachment connects easily using a plug-and-play system, so you can switch between styling options in just seconds.

Designer: LAYER and Shark Beauty

![]()

![]()

This innovation isn’t just about convenience. FlexFusion was carefully engineered to suit all hair types and styling preferences, reducing the need for multiple devices and making it easier to keep your space tidy. The device features a digital interface with precise temperature and airflow controls, including a special “Scalp Shield” mode that helps protect delicate new hair growth from excessive heat. The controls are designed around an intuitive “island” system that makes it easy to find and adjust the settings you need, even if you’re new to advanced styling tools.

![]()

![]()

![]()

Design isn’t an afterthought here. FlexFusion’s sculptural, ergonomic shape is inspired by the natural curves of your hand and scalp, providing a secure grip and comfortable experience every time you style. Subtle design cues like creased transitions and chamfered edges guide your hands and highlight key performance areas, while a satin metallic finish adds a touch of luxury and sophistication to your vanity. Air inlets and outlets are positioned for efficiency and precision, blending seamlessly into the tool’s sleek silhouette.

![]()

![]()

The launch of FlexFusion is part of an ongoing creative partnership between LAYER and Shark Beauty, aimed at redefining the aesthetics and usability of everyday beauty tools. Their shared goal is to create a unified design language for the brand’s portfolio, making beauty routines more enjoyable and accessible for everyone. Benjamin Hubert, the founder of LAYER, describes FlexFusion as a product that “simplifies the beauty process without compromising on performance.” It’s a vision that feels right on target for today’s busy women, collectors, and anyone who wants their self-care routine to feel as beautiful and thoughtful as the results.

![]()

![]()

With its blend of cutting-edge function and elegant design, FlexFusion is poised to become an essential for those who want to streamline their styling routine while elevating the everyday ritual of self-care. If you’re looking to replace your crowded drawer of hair tools with a single stylish solution, FlexFusion could be your next beauty must-have.

![]()

![]()

The post FlexFusion brings 5 hair styling tools in one device first appeared on Yanko Design.

Most 3D printers force you to choose between speed, color, quality, or price. You can have fast prints, but only in one color. Multi-color prints take forever and waste enormous amounts of filament. Professional results require expensive machines that most makers can’t justify.

The Snapmaker U1 Color 3D Printer refuses to accept these compromises. This isn’t just another incremental improvement but a fundamental rethinking of how desktop 3D printing should work. It’s designed for makers who want everything: speed, color, precision, and sustainability.

Designer: You Li

Click Here to Buy Now: $749 $999 ($250 off). Hurry, only 411/3500 left! Raised over $6.2 million.

Traditional consumer 3D printers rely on single-nozzle systems that require time-consuming filament swaps and produce mountains of waste. Every color change means flushing perfectly good material, creating wasteful piles of purge that often use more filament than the actual print.

The Snapmaker U1 introduces a four-head tool-changing system that allows multi-color and multi-material prints in a single job. Each toolhead is physically separate, eliminating cross-contamination and enabling seamless transitions between colors and materials. This approach mirrors professional industrial printers but brings the technology to desktop users.

Snapmaker has built a reputation for reliable, innovative desktop fabrication tools that actually deliver on their promises. The U1 continues this tradition with a modular CoreXY design that looks as advanced as it performs. With an aesthetic plastic shell and careful attention to engineering, this creation tool is designed from the get-go to be accessible, both in terms of cost as well as functionality.

The machine’s visual design reflects its technical sophistication. The Snapmaker U1 has a transparent back panel that complements its open front, allowing it to visually flow more naturally into your workspace. Clean lines, thoughtful component placement, and a transparent approach to showing its capabilities create a printer that’s as much a statement piece as a production tool.

The SnapSwap![]() system enables physical toolhead swaps in just five seconds, transforming how multi-material printing works. This avoids the little balls of perfectly good filament, wasted by typical AMS style machines, and reduces filament waste by up to 80% compared to traditional systems. The precision is remarkable: automatic toolhead alignment stays within 0.04mm for sharp, clean prints.

system enables physical toolhead swaps in just five seconds, transforming how multi-material printing works. This avoids the little balls of perfectly good filament, wasted by typical AMS style machines, and reduces filament waste by up to 80% compared to traditional systems. The precision is remarkable: automatic toolhead alignment stays within 0.04mm for sharp, clean prints.

Consider a four-color dragon figure that takes five hours on the U1 versus thirty hours on conventional printers. The U1 uses just 96 grams of filament, while others waste 483 grams on the same model. It even boasts up to 80% electricity savings! That’s not just efficiency but a fundamental shift toward sustainable making.

The CoreXY motion system delivers print speeds up to 300mm/s with travel speeds reaching 500mm/s and acceleration hitting 20,000mm/s². These aren’t just impressive numbers but translate into real-world time savings without sacrificing quality. Smart calibration features include mesh bed leveling and active vibration control.

The large 270 x 270 x 270mm build volume accommodates both ambitious single prints and efficient batch production. Pressure advance compensates for flow delays, ensuring accurate prints with crisp details even at high speeds. Stainless steel nozzles support a wide range of filaments, with hardened steel nozzles and even new nozzle sizes on the way.

The SnapSwap![]() system’s waste reduction goes beyond cost savings to address environmental concerns. Using large amounts of filament typically wasted during color changes aligns with growing demands for sustainable maker tools. This isn’t greenwashing but genuine material efficiency.

system’s waste reduction goes beyond cost savings to address environmental concerns. Using large amounts of filament typically wasted during color changes aligns with growing demands for sustainable maker tools. This isn’t greenwashing but genuine material efficiency.

The environmental impact extends beyond individual projects. When scaled across thousands of users, the waste reduction becomes significant. It’s the kind of innovation that makes 3D printing more responsible without sacrificing capability.

The automatic filament system holds four spools with RFID recognition, auto-loading, and backup mode functionality. This eliminates manual intervention during long prints and ensures consistent material flow. The built-in AI camera captures time-lapses while monitoring for anomalies and print failures.

Snapmaker Orca Slicer provides engineer-tested profiles optimized for the U1’s capabilities. The companion app enables remote print management, real-time monitoring, and instant alerts when issues arise. Failure detection covers air printing, filament run-out, and power loss recovery.

The Snapmaker U1 represents a leap forward in accessible, high-performance 3D printing. It empowers makers to create more while wasting less, exploring new creative possibilities in a machine that’s as visually impressive as it is technically advanced. Sometimes the best innovations come from refusing to accept the limitations everyone else considers inevitable.

Click Here to Buy Now: $749 $999 ($250 off). Hurry, only 411/3500 left! Raised over $6.2 million.

The post Snapmaker U1 Color 3D Printer Blends Blazing Speed With Less Waste first appeared on Yanko Design.

Imaginez un instant que soyez contrebandier de puces électroniques… Vous venez de recevoir un serveur Dell flambant neuf bourré de puces Nvidia H100 que vous comptez évidemment revendre à prix d’or sur le marché chinois.

Alors vous ouvrez le carton, pour inspecter minutieusement chaque recoin du paquet et là, Ô surprise, vous trouvez un petit boîtier de la taille d’un smartphone bien caché dans l’emballage. Félicitations !! Vous venez de vous faire griller par l’Oncle Sam !

Cette histoire n’est pas tirée d’un film d’espionnage de mon cerveau torturé mais bien de la réalité car selon Reuters, les autorités américaines ont placé secrètement des trackers GPS dans certaines livraisons de puces IA qu’elles considèrent à haut risque de détournement vers la Chine.

Et apparemment, ça fonctionne plutôt bien puisque deux ressortissants chinois ont été arrêtés début août pour avoir tenté d’exporter illégalement pour des dizaines de millions de dollars de puces Nvidia vers l’Empire du Milieu.

Et le niveau de sophistication de l’opération est top, car les trackers ne sont pas juste collés sur les cartons. Dans un cas documenté datant de 2024, les autorités ont carrément placé plusieurs types de dispositifs. A la fois des gros trackers visibles sur les boîtes d’expédition pour le suivi basique, et des plus petits, bien planqués dans l’emballage voire directement dans les serveurs eux-mêmes. C’est malin !!

Mais ces contrebandiers ne sont pas dupes non plus. On peut lire par exemple dans les documents judiciaires, que l’un des accusés avait prévenu son complice : “Fais attention de bien chercher s’il y a un tracker dessus, tu dois regarder attentivement”. Ces types passent leur temps à démonter des serveurs Dell et Super Micro pour vérifier qu’il n’y a pas de mouchard caché quelque part… Bref, ce sont devenu des champions au jeu du chat et de la souris avec les autorités.

Bien sûr cette pratique n’est pas nouvelle du tout. Les États-Unis utilisent des trackers pour surveiller les exportations sensibles depuis des décennies. En 1985 déjà, Hughes Aircraft avait vu ses équipements interceptés par les douanes américaines qui y avaient installé un dispositif de localisation. Sauf qu’à l’époque, on parlait de pièces d’avion, pas de puces IA capables de faire tourner des LLM.

Et l’ampleur de ce trafic est vertigineuse. Malgré les restrictions imposées depuis 2022, au moins 1 milliard de dollars de puces Nvidia auraient été introduites illégalement en Chine rien qu’au cours des trois derniers mois. Les contrebandiers passent par la Malaisie, Singapour ou les Émirats arabes unis pour brouiller les pistes. C’est un vrai business qui rapporte gros quand on sait qu’une seule puce H100 peut se négocier plusieurs dizaines de milliers de dollars au marché noir.

Et pendant ce temps, la tension monte entre Pékin et les fabricants de puces. Le 31 juillet dernier, l’administration chinoise du cyberespace a convoqué Nvidia pour lui demander des explications sur les risques de “backdoors” dans ses puces H20. Les Chinois craignaient que les Américains puissent désactiver à distance leurs précieux processeurs ou les utiliser pour les espionner. Nvidia a bien sûr démenti catégoriquement (What else !?), expliquant que mettre des backdoors dans des puces serait un cadeau fait aux hackers et aux acteurs hostiles et que ça mettrait à risque l’infrastructure numérique mondiale.

Au milieu de ce bras de fer géopolitique, les entreprises comme Dell et Super Micro se retrouvent donc coincées. Dell affirme ne pas être au courant de cette initiative gouvernementale de tracking, tandis que Super Micro refuse de commenter ses “pratiques et politiques de sécurité”. Nvidia et AMD, eux, préfèrent ne pas répondre du tout. On les comprend, c’est un sujet sensible…

Cette histoire de trackers dans les puces révèle surtout l’absurdité de la situation actuelle car d’un côté, les États-Unis tentent désespérément d’empêcher la Chine d’accéder aux technologies d’IA les plus avancées. Et de l’autre, la demande chinoise est tellement forte que des réseaux entiers de contrebande se sont organisés pour contourner l’embargo.

Le pire c’est que les autorités américaines envisagent maintenant d’obliger les fabricants à intégrer directement des systèmes de localisation DANS leurs puces. Oui, oui… Vous vous doutez, c’est une proposition qui fait bondir l’industrie, car elle créerait une vulnérabilité permanente dans le hardware. Comme l’a dit David Reber, le responsable sécurité de Nvidia, intégrer un kill switch dans une puce, serait “une invitation ouverte au désastre”, et je suis assez d’accord avec lui.

Bref, bon courage aux chinois ^^

![]()

C’est vraiment paradoxal, mais plus on avance dans la technologie, plus on se tourne vers ce qui est vraiment, vraiment vieux. Et là, je ne vous parle pas de vos vieux CD-ROM Windows 95, non, non, mais de trucs qui traînent sur Terre depuis des milliards d’années (comme Bayrou ^^).

Une équipe de chercheurs de l’Université de Pennsylvanie vient de faire une découverte assez dingue. Ils ont utilisé une IA pour fouiller dans les protéines d’organismes appelés Archaea, des microbes tellement anciens qu’ils étaient déjà là avant que les bactéries ne deviennent “mainstream”. Ces bestioles survivent dans des conditions extrêmes : sources d’eau bouillante acide, cheminées volcaniques sous-marines, lacs salés où rien d’autre ne peut vivre. Bref, les endroits où même Bear Grylls ne mettrait pas les pieds.

![]()

Et ce qui est fou, c’est que ces microbes ont développé des mécanismes de défense complètement différents de ce qu’on connaît. Au lieu d’attaquer la membrane externe des bactéries comme le font la plupart des antibiotiques actuels, les composés découverts (baptisés sans originalité des “archaeasins”) s’attaquent directement aux signaux électriques à l’intérieur des cellules. C’est un peu comme si au lieu de défoncer la porte d’entrée, ils coupaient directement le disjoncteur de la maison.

L’équipe dirigée par César de la Fuente a utilisé un outil d’IA appelé APEX 1.1 pour scanner 233 espèces d’Archaea. Résultat, ils ont découvert plus de 12 600 candidats antibiotiques potentiels. Sur les 80 qu’ils ont synthétisés et testés en labo, 93% ont montré une activité antimicrobienne contre au moins une bactérie pathogène. C’est un taux de réussite assez impressionnant quand on sait que d’habitude, on tourne plutôt autour de quelques pourcents.

Selon l’OMS, on fait face en ce moment à une crise majeure avec 24 pathogènes prioritaires qui nécessitent de nouveaux antibiotiques de toute urgence. Seulement, voilà, le pipeline de développement de nouveaux antibiotiques est quasiment à sec, avec seulement 27 antibiotiques en développement clinique dont seulement 6 considérés comme vraiment innovants. Et pendant ce temps, les bactéries résistantes continuent de proliférer… Cela génère 2,8 millions d’infections résistantes aux antibiotiques se produisent chaque année rien qu’aux États-Unis.

Un des archaeasins testés, le numéro 73 (ils sont pas très créatifs pour les noms, j’avoue…), s’est montré aussi efficace que la polymyxine B sur des souris infectées. Pour ceux qui ne connaissent pas, la polymyxine B c’est un peu l’arme de dernier recours contre les infections multi-résistantes. C’est le genre de truc qu’on sort quand plus rien d’autre ne marche. Vous avez intérêt à bien bien prendre vos probiotiques après celui-là, pour ne pas repeindre encore une fois l’appart.

C’est donc un tout nouveau terrain de jeu qui s’ouvre car jusqu’à présent, la recherche d’antibiotiques s’est concentrée sur les bactéries, les champignons et parfois les plantes. Les Archaea, c’est donc un domaine complètement inexploré. Et vu qu’ils représentent une branche entière de l’arbre du vivant, distincte des bactéries et de tout le reste, le potentiel est énorme !

D’ailleurs, ce n’est pas la première fois que l’équipe de de la Fuente utilise l’IA pour chercher des antibiotiques dans des endroits improbables (oups, non pas là). Ils avaient déjà scanné l’ADN d’organismes éteints comme le mammouth laineux et même analysé les composés chimiques dans les venins d’animaux. L’idée, c’est que l’évolution a déjà fait le boulot pendant des millions d’années, alors il suffit de savoir où chercher.

![]()

Les chercheurs prévoient donc maintenant d’améliorer APEX pour qu’il puisse prédire l’activité antibiotique basée sur la structure 3D des molécules, et pas seulement leur séquence. L’objectif à terme, c’est évidemment d’arriver jusqu’aux essais cliniques sur l’homme. Mais ça, c’est encore une autre paire de manches qui prendra plusieurs années…

Bref, comme quoi, des solutions aux problèmes modernes se cachent parfois dans ce qu’il y a de plus ancien et ces microbes qui barbotent tranquillement dans leur soupe acide depuis des milliards d’années pourraient bien nous sauver la mise face aux superbactéries du 21e siècle qui déboulent en masse, notamment à cause du changement climatique.

![]()

Ce serait quoi un monde où les bugs de sécurité se font corriger avant même que les hackers ne les trouvent ? Ce serait plus calme non ? J’écrirais moins sur les failles de sécurité cela dit, mais ça me ferais plus de temps pour chiller dans le hamac. Breeeef, ça va peut-être se produire bientôt car c’est exactement ce que vient de rendre possible Trail of Bits en libérant Buttercup, leur système AI qui a décroché la deuxième place et 3 millions de dollars au challenge AIxCC du DARPA.

Et c’est maintenant open source et ça tourne sur votre laptop.

La tendance actuelle c’est une explosion des vulnérabilités… y’a plus de code produit que jamais, des dépendances partout, et des hackers de plus en plus organisés. Donc les équipes de sécurité sont débordées et passent leur temps à courir après les failles. Heureusement, Buttercup vient inverser complètement la donne en automatisant tout le processus, de la détection au patch.

![]()

Ce qui rend ce système spécial, c’est qu’il combine le meilleur des deux mondes. D’un côté, les techniques classiques de cybersécurité comme le fuzzing (bombarder le code avec des entrées aléatoires pour le faire planter) et l’analyse statique. Et de l’autre, sept agents IA différents qui collaborent pour comprendre le contexte, générer des patchs et vérifier qu’ils ne cassent rien d’autre.

Lorsqu’on lui confie une analyse, d’abord, Buttercup lance donc une campagne de fuzzing augmentée par IA sur votre code. Et au lieu de tester bêtement des entrées aléatoires, l’IA apprend quels patterns ont le plus de chances de révéler des bugs. Puis, quand une vulnérabilité est trouvée, le système utilise des outils comme tree-sitter et CodeQuery pour créer un modèle complet du programme et comprendre exactement comment le bug s’intègre dans l’architecture globale.

Et c’est là que ça devient vraiment intéressant car les sept agents IA entrent alors en action, avec chacun avec sa spécialité. L’un analyse le bug, l’autre génère des propositions de patch, un troisième vérifie que le patch ne casse pas les tests existants, et ainsi de suite. Ils se coordonnent tous pour produire un patch normalement robuste qui corrige vraiment le problème sans créer de régression.

![]()

Pendant la compétition DARPA à DEF CON 33, Buttercup a impressionné tout le monde. Le système a trouvé et patché des vulnérabilités dans 20 des 25 CWEs les plus dangereux selon MITRE. Et je vous parle de trucs sérieux : buffer overflows, injections SQL, race conditions… Trail of Bits a même reçu le prix “LOC Ness Monster” pour avoir soumis un patch de plus de 300 lignes qui fonctionnait parfaitement.

Ce qui est fou, c’est qu’ils ont obtenu ces résultats en utilisant uniquement des modèles IA moins chers, non-reasoning, et pas les gros modèles de raisonnement ultra-chers. Ça veut dire que c’est accessible pour des projets normaux, pas seulement pour les géants de la tech avec des budgets illimités.

L’installation est vraiment simple pour un outil de cette complexité :

git clone --recurse-submodules https://github.com/trailofbits/buttercup.git

cd buttercup

make setup-local

make deploy-local

Bon, il vous faudra quand même 8 cœurs CPU, 16GB de RAM et environ 100GB d’espace disque. Plus des clés API pour OpenAI ou Anthropic si vous voulez utiliser les fonctionnalités IA. Mais comparé à d’autres outils de sécurité enterprise, c’est vraiment raisonnable. Rassurez-vous aussi, il est possible de fixer un budget maximum en conso API.

Le système supporte actuellement le C et le Java, avec une compatibilité OSS-Fuzz pour s’intégrer facilement dans vos pipelines existants. Il y a même une interface web pour monitorer les tâches en cours et voir exactement ce que fait le système.

Ce qui me plaît vraiment dans ce projet, c’est surtout la philosophie derrière car au lieu de garder cette technologie secrète ou de la vendre hyper cher, Trail of Bits a décidé de tout libérer. Ils ont même créé une version “laptop-friendly” spécialement optimisée pour tourner sur des machines normales, pas juste des clusters de serveurs.

Dans le contexte actuel, c’est une vraie révolution. Google a par exemple montré que son IA peut trouver de nouvelles vulnérabilités dans des projets open source majeurs et Meta développe AutoPatchBench pour standardiser la réparation automatique. Mais Buttercup est le premier système complet, de bout en bout, et open source.

Avec cet outil, des projets open source pourrait se patcher automatiquement et les développeurs pourraient alors se concentrer sur les features au lieu de passer des heures à debugger. Bien sûr, ce n’est pas magique et Buttercup ne remplacera pas les experts en sécurité mais c’est un outil incroyablement puissant qui peut automatiser la partie la plus répétitive et chronophage du travail. Et vu que c’est open source, la communauté peut l’améliorer, l’adapter à ses besoins, créer des plugins…

Donc, si vous bossez dans le dev ou la sécurité, allez jeter un œil au GitHub de Buttercup et qui sait, peut-être qu’un jour on regardera en arrière et on se demandera comment on faisait sans IA pour sécuriser notre code.

![]()

Ce serait cool non, si on pouvait transformer n’importe quelle lampe de bureau en détecteur de deepfakes, non ?

Car le problème avec les deepfakes aujourd’hui, c’est qu’on court constamment après les faussaires. Ils ont accès aux mêmes vidéos authentiques que nous, aux mêmes outils d’édition ultra-sophistiqués, et l’IA apprend tellement vite qu’elle produit des faux quasi-indétectables. Il leur est donc très facile de reprendre une vraie vidéo et de la trafiquer légèrement pour manipuler les opinions.

Il faudrait donc une sorte de bouclier anti-manipulation-IA pour empêcher toute manip ultérieure d’une captation vidéo. Et bien c’est exactement ce que viennent de réussir des chercheurs de l’université Cornell, et leur technique est brillante… sans mauvais jeu de mots, vous me connaissez ^^.

![]()

Abe Davis, à gauche, professeur adjoint d’informatique au Cornell Ann S. Bowers College of Computing and Information Science, et Peter Michael, étudiant diplômé.

Comme l’explique Abe Davis de Cornell : “La vidéo était considérée comme une source de vérité, mais ce n’est plus une hypothèse qu’on peut faire”. Donc, plutôt que de jouer éternellement au chat et à la souris avec la connerie des gens et le talent des faussaires, l’équipe de Cornell a eu une idée géniale : Et si on marquait les vidéos dès leur création, avec un code secret planqué dans la lumière elle-même ?

Leur technologie, baptisée NCI pour “noise-coded illumination”, fonctionne en ajoutant des fluctuations microscopiques à l’éclairage. Ces variations sont totalement invisibles à l’œil nu car votre cerveau les interprète comme du bruit lumineux normal. Mais une caméra, elle pourra tout capter.

Le truc vraiment cool, c’est que chaque source lumineuse peut avoir son propre code secret comme ça vous pouvez programmer votre écran d’ordinateur, vos lampes de bureau, même l’éclairage d’une salle de conférence entière. Et pour les vieilles lampes qui ne sont pas connectées, une simple puce de la taille d’un timbre-poste suffit à les transformer en watermark lumineux.

Mais ensuite, comment ça détecte les fakes ? Et bien c’est là que ça devient vraiment intéressant car le watermark enregistre en permanence une version basse résolution de ce qui se passe sous cet éclairage, avec un horodatage. Les chercheurs appellent ça des “code videos”. Ainsi, quand quelqu’un manipule la vidéo, que ce soit pour insérer un deepfake, changer la vitesse, ou ajouter des éléments, les parties modifiées ne correspondent plus aux code videos. C’est comme si la lumière gardait un registre secret de tout ce qui s’est vraiment passé.

Comme ça, si un petit malin essaie de générer une fausse vidéo avec l’IA à partir d’une vraie vidéo, les code videos ressembleront alors à du charabia aléatoire, ce qui trahira immédiatement la supercherie. Et même si le faussaire connaît la technique et arrive à décoder les codes secrets, il devrait falsifier chaque code video séparément, et s’assurer qu’ils correspondent tous parfaitement entre eux. Autant dire que c’est mission impossible.

Peter Michael, l’étudiant qui a mené les travaux, a présenté cette innovation au SIGGRAPH 2025 à Vancouver et les tests sont vraiment impressionnant car la technique résiste aux compressions vidéo agressives, aux mouvements de caméra, aux flashs, et fonctionne même en extérieur avec différents tons de peau.

Pendant ce temps, la course à l’armement anti-deepfake continue. Le MIT a son projet Detect Fakes actif depuis 2020. Microsoft a son Video Authenticator qui analyse les pixels pour détecter les anomalies. Intel mise sur son FakeCatcher qui atteint 96% de précision en détectant les variations de flux sanguin dans les vidéos (parce que oui, même les meilleurs deepfakes n’arrivent pas encore à reproduire parfaitement les micro-changements de couleur de la peau dus à la circulation sanguine).

Reality Defender, de son côté, utilise une approche multi-modèle qui n’a pas besoin de watermarks préalables. Ils analysent images, vidéos, audio et texte en temps réel pour repérer les manipulations… C’est impressionnant, mais ça reste une approche défensive qui court après les faussaires et n’empêche pas leur “travail”.

Et c’est ça qui rend la solution de Cornell vraiment prometteuse… C’est parce qu’elle est proactive. Plus besoin d’analyser après coup si une vidéo est truquée puisque la preuve d’authenticité est encodée dedans dès le départ. On pourrait sécuriser comme ça des salles de presse équipées de ce système, des interviews officielles protégées par défaut, ou même le siège de l’ONU avec un éclairage anti-deepfake intégré.

Bien sûr, ce n’est pas la solution miracle et Davis lui-même admet que “c’est un problème qui ne va pas disparaître, et qui va même devenir plus difficile” car les faussaires trouveront de nouvelles parades, c’est certain. Mais pour l’instant, cette technologie donne une longueur d’avance cruciale aux défenseurs de la vérité.

Qui aurait cru qu’on combattrait les deepfakes avec une simple lampe de bureau ??

![]()

CEO of Meta, Mark Zuckerberg is seen during a Senate Judiciary Committee hearing with representatives of social media companies at the Dirksen Senate Office Building on Wednesday January 31, 2024 in Washington, DC.

![]()

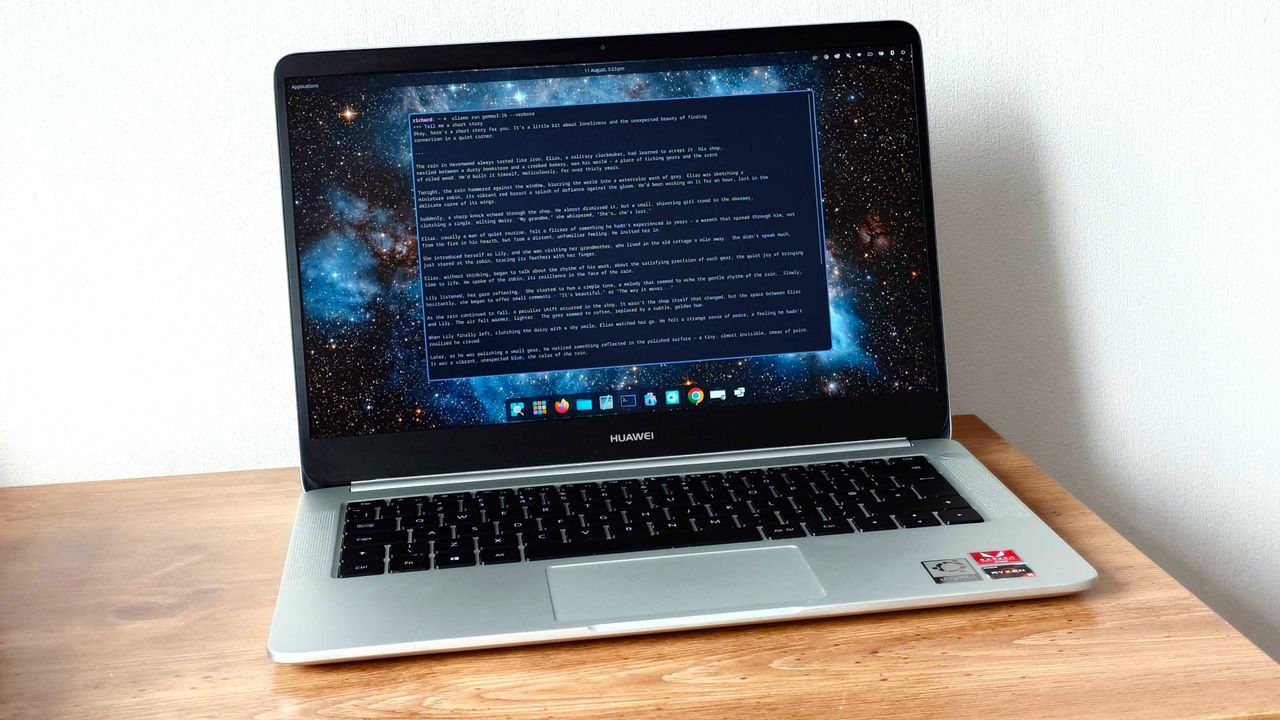

A Huawei MateBook D running Ollama on Fedora 42

![]()

Sam Altman, CEO of OpenAI, the company behind ChatGPT, speaks at a joint press conference announcing a strategic partnership with Kakao at the Plaza Hotel in Seoul, South Korea, on February 4, 2025.

![]()