BugStalker – Le debugger Rust puissant et convivial

![]()

Je sais, convivial c’est un mot bizarre pour parler d’un outil de débogage, mais celui-ci va vous faire kiffer si vous codez en Rust. Ça s’appelle BugStalker et c’est juste le debugger qu’il vous faut pour traquer les bugs vicieux dans vos programmes puisqu’il comprend toutes les subtilités du langage.

Ça veut dire qu’il sait gérer les types Rust complexes comme les vecteurs, les pointeurs intelligents et même les variables locales des threads. Et il ne fait pas que les afficher joliment, il vous permet carrément d’interagir avec !

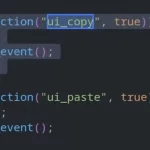

Vous pouvez poser des breakpoints où vous voulez dans votre code, que ce soit sur une ligne précise, une fonction ou même une instruction assembleur. Et quand votre programme s’arrête sur un breakpoint, vous pouvez contrôler son exécution pas à pas, rentrer dans les fonctions ou les sauter, tout ça à la volée.

Et si vous avez besoin d’inspecter les données de votre programme, il a ce qu’il vous faut dans le ventre. Vous pouvez par exemple évaluer des expressions pour afficher les variables locales et globales, les arguments des fonctions, et même découper des tableaux ou des vecteurs pour voir ce qui se cache dedans.

L’outil vous propose deux interfaces au choix : une classique en ligne de commande, et une interface graphique en mode TUI (Text User Interface) qui claque. Et le kif, c’est que vous pouvez passer de l’une à l’autre quand vous voulez pendant une session de débogage !

Ah et j’allais oublier un truc énorme : les Oracles ! Non, je ne parle pas de la boîte qui fait des bases de données, mais d’une fonctionnalité trop stylée de BugStalker. En gros, c’est des modules qui viennent se greffer au debugger pour vous filer des infos sur des aspects spécifiques de votre programme. Par exemple, l’Oracle Tokio vous donne des insights sur le runtime Tokio si vous faites de l’asynchrone, sans avoir à modifier votre code. Trop fort !

Bon allez, je vais pas vous faire languir plus longtemps. Si vous voulez essayer, c’est tout simple, vous installez ça avec cargo :

cargo install bugstalker

et hop, vous êtes prêts à déboguer comme des pros. Et si jamais vous avez un souci avec la dépendance libunwind, y a même une version sans, mais entre nous, libunwind c’est quand même mieux.

Franchement, je « ne contracte pas » quand je vous dis que BugStalker c’est le debugger qu’il vous faut pour vos projets Rust. Avec lui, traquer les bugs c’est presque devenu un sport national, alors go sur https://github.com/godzie44/BugStalker , votre code Rust vous dira merci !

Allez, sur ce je vous laisse, j’ai un programme à déboguer moi (non, mon code est parfait).

![]()